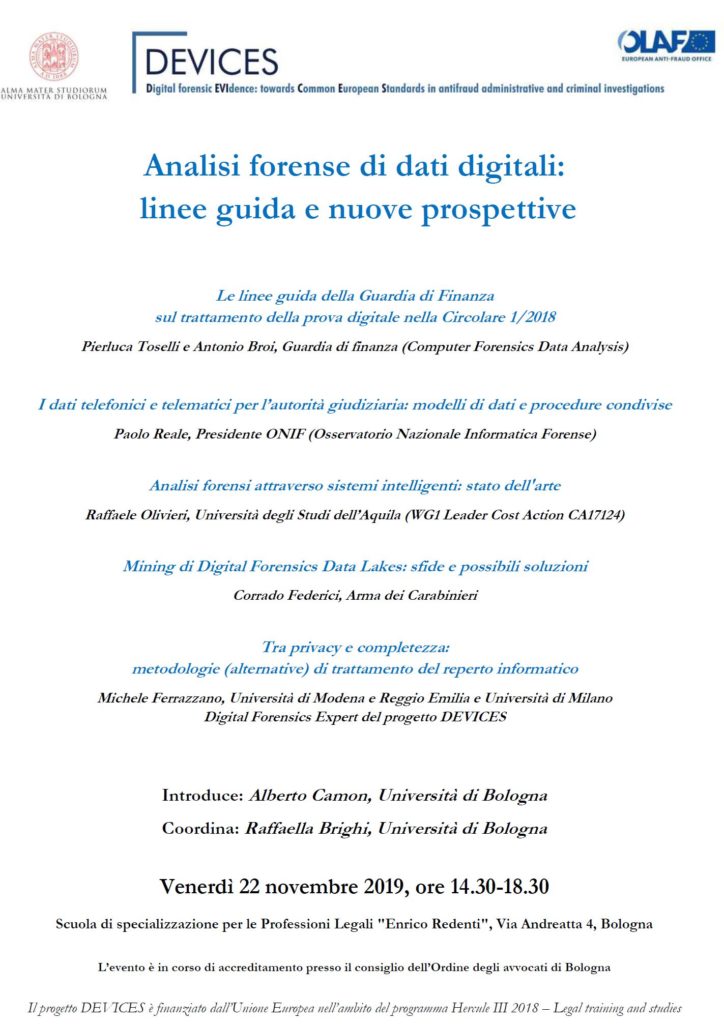

Venerdì 22 novembre 2019 si è svolto presso l’Aula Magna della scuola di specializzazione per le professioni legali “Enrico Redenti” dell’Università di Bologna il seminario “Analisi Forense di dati digitali, linee guida e nuove prospettive”, organizzato nell’ambito del progetto di ricerca “Devices” finanziato dall’Unione Europea.

Dopo una precedente conferenza nell’ambito dello stesso progetto di ricerca che aveva trattato la tematica della raccolta di dati digitali da una prospettiva processual-penalistica, la conferenza del 22 novembre ha analizzato, con la partecipazione di relatori qualificati, la questione da un punto di vista informatico-forense, con gli interventi di chi, o come forze di polizia o come consulenti di parti private, si occupa materialmente della raccolta e dell’analisi di questi dati e delle problematiche derivanti dalla raccolta di dati a livello sovranazionale.

Dopo l’introduzione da parte di Alberto Camon (professore di procedura penale dell’Università di Bologna), Raffaella Brighi (professoressa di informatica forense dell’Università di Bologna) ha coordinato il programma del pomeriggio di studi.

Relazioni del convegno Analisi forense di dati digitali: linee guida e nuove prospettive

Il primo intervento è stato tenuto dagli esperti della Guardia di Finanza (c.d. CFDA) Pierluca Toselli e Antonio Broi che hanno relazionato sulle metodologie di raccolta dati da parte del loro Corpo di appartenenza.

Partendo dalla Circolare n. 1/2018 della Guardia di Finanza che ha dato alcune linee guida importanti sulla acquisizione dei dati digitali nelle indagini di competenza del Corpo, i relatori hanno illustrato le varie modalità di acquisizione dei dati, che sono basate non su una procedura definita ma su best practices, dalle ISO dedicate (in particolare la ISO/IEC 27037) e dalle normative vigenti, fra cui la nota legge n. 48 del 2008.

Il successivo intervento, a cura dell’Ing. Paolo Reale, presidente della Associazione ONIF, ha avuto come contenuto il tema del trattamento dei dati dei tabulati telefonici, mettendo in rilievo le difficoltà per gli analisti che derivano dal fatto che il dato viene presentato in maniera analogica e in modalità differente da un gestore telefonico all’altro, auspicando che si arrivi ad un modello unico per tutti.

Il Dr. Raffaele Olivieri dell’Università dell’Aquila ha presentato uno studio sull’uso dei sistemi di intelligenza artificiale per l’analisi forense, aprendo di fatto una prospettiva del tutto nuova i cui sviluppi saranno da seguire nel prossimo futuro, anche se il relatore ha concluso il suo intervento affermando che i risultati così ottenuti dovranno trovare comunque dei riscontri con altre attività investigative.

L ‘ intervento del Dr. Ing. Corrado Federici dell’Arma dei Carabinieri è stato dedicato a “Mining di Digital Forensics Data Leaks: sfide e possibili soluzioni” e ha riguardato le sfide e le problematiche poste alla Digital Forensics dai Big Data, dall’incremento dei volumi dei dati e dalla eterogeneità delle sorgenti dei dati medesimi, proponendo un modello di riferimento da impiegare nel caso di un “Data Leak”.

Ha concluso la serie di interventi il Dr. Michele Ferrazzano, professore a contratto di Computer forensics all’Università di Milano ed esperto di digital forensics del progetto. Nel suo intervento ha presentato alcune metodologie alternative di trattamento e analisi del dato digitale per andare incontro alle esigenze delle parti che chiedono riservatezza dei dati non pertinenti con le indagini.

Non sono mancati durante e al termine della conferenza momenti di confronto fra il pubblico presente e i relatori che hanno risposto alle varie domande formulate per chiarire meglio alcuni punti degli interventi appena presentati.

Un evento di alto contenuto scientifico che sicuramente ha contribuito a fare chiarezza e a comprendere la necessità di adottare linee condivise di analisi dei dati digitali a livello europeo che permettano di superare le varie criticità che i vari interventi del seminario non hanno mancato di segnalare.

di Alfonso Buccini